L’antenato di iPhone non è un datato e ingombrante computer Apple, ma un home computer creato in Regno Unito nella metà degli anni ’80: si chiama Archimedes ed è stato costruito da Acorn. Le peculiarità di Archimedes sono diverse, quelle che qui ci interessano sono principalmente due: è stato il primo computer a funzionare con un processore ARM e lo sviluppo del suo processore innovativo è stato voluto e finanziato da Apple.

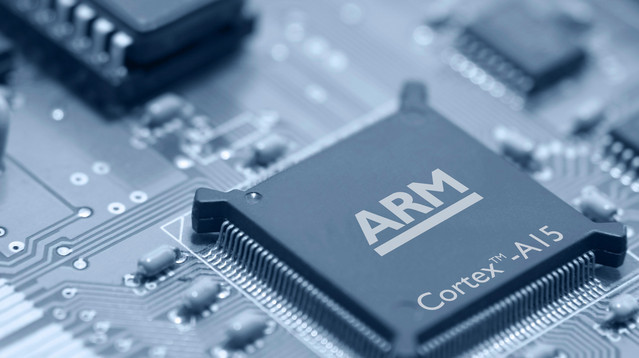

Il risultato di questo progetto allora segretissimo è proprio il processore ARM, sigla che inizialmente indicava Acorn RISC Machine ma che successivamente si trasformò in Advanced RISC Machine, quando la società si progettazione e sviluppo fu scorporata da Acorn per diventare ancora più indipendente. La tecnologia RISC, da Reduced Instruction Set Computer, indica un processore dotato di set di istruzioni volutamente limitato, ma in grado di eseguirle molto più velocemente, una semplificazione fondamentale per ridurre il numero di transistor e i consumi.

Quando fu presentato il primo Archimedes nel 1987 funzionava con ARM2, il primo ad essere costruito di questa famiglia destinata a diventare diffusissima, assicurando a questo home computer prestazioni da capogiro, naturalmente per l’epoca. Per esempio mentre il Motorola 68000 (circa 70mila transistor) impiegato in Amiga, Atari ST e anche nel primo Macintosh di Apple funzionava a 8 MHz ed era in grado di erogare circa 1 MIPS, milioni di istruzioni al secondo, ARM2 (circa 30mila transistor, la metà!) alla stessa velocità erogava una potenza compresa tra 4,5 e 4,8 MIPS. Le prestazioni elevate, la bontà del sistema operativo e del software a corredo valsero ad Archimedes il titolo di home computer più veloce.

La società fondatrice Acorn ha smesso di produrre computer pochi anni dopo, ma la costola ARM, finanziata da Apple, ha continuato a migliorare l’architettura ARM fino ai livelli oggi evidenti e sotto gli occhi di tutti. Anche se Intel per marchio e marketing è il nome comunemente associato ai processori, la quantità di dispositivi che funzionano con ARM è di una scala decisamente superiore. Non solo tablet e smartphone, ma anche router, NAS, televisori smart, schede di controllo, console portatili e molto altro ancora funzionano con un processore con architettura ARM.

La storia della nascita di ARM è interessante ma la parte migliore, secondo molti, deve ancora arrivare. Con il continuo miglioramento e potenziamento i processori ARM potrebbero presto uscire dai dispositivi super compatti in cui il risparmio energetico è essenziale: tra non molto potrebbero arrivare anche nei computer portatili e forse chissà persino nei desktop.