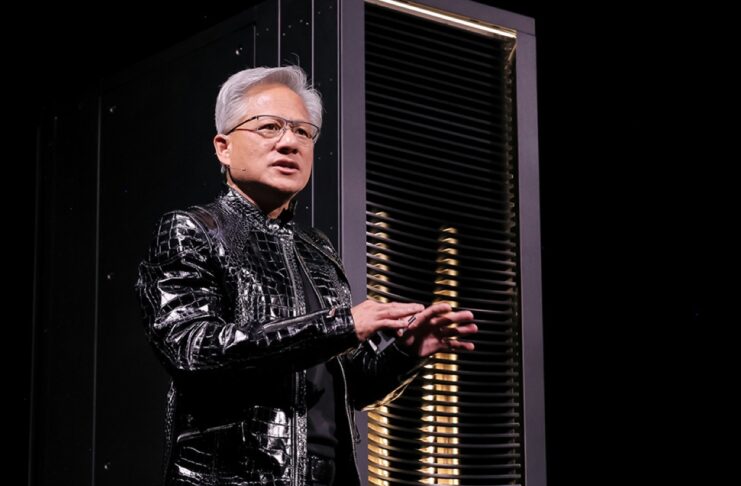

Un supercomputer successore di Blackwell e la guida autonoma. Poi una serie di annunci legati alle infrastrutture che generano il mondo Ai. Nulla che abbia a che fare con la missione storica: le GPU per il pubblico consumer. La presentazione di Nvidia al CES 2026 ha chiarito in via definiva con il keynote del CEO Jensen Huang il suo ruolo di architetto dell’infrastruttura globale dell’intelligenza artificiale lasciandosi alle spalle quello di una azienda nata per videogiochi e grafica.

Vera Rubin e l’infrastruttura AI

Il centro della presentazione di Nvidia al CES 2026 è stato Vera Rubin, la nuova piattaforma che raccoglie l’eredità di Blackwell e segna un ulteriore cambio di scala nell’infrastruttura per l’intelligenza artificiale. Non si tratta di un singolo chip, ma di un sistema progettato come un supercomputer integrato, in cui ogni componente è sviluppato insieme agli altri.

Nvidia parla esplicitamente di extreme co-design: GPU, CPU, interconnessioni di rete e storage non sono più elementi separati, ma parti di un’unica architettura pensata fin dall’inizio per l’addestramento e l’inferenza dei modelli AI. L’obiettivo è eliminare i colli di bottiglia che storicamente hanno limitato i sistemi distribuiti, soprattutto quando si lavora su modelli di grandi dimensioni.

Secondo Jensen Huang, Vera Rubin consente di ottenere un miglioramento radicale sul piano economico prima ancora che prestazionale. Nvidia sostiene che la piattaforma permetterà di ridurre il costo di generazione dei token a circa un decimo rispetto alla precedente architettura Blackwell, con benefici diretti su time-to-market, consumo energetico e sostenibilità dei progetti AI su larga scala.

Un elemento chiave dell’architettura è l’introduzione di nuove soluzioni di storage native per l’AI, pensate per gestire contesti molto lunghi durante l’inferenza. Questo approccio consente di aumentare il numero di token processati al secondo e di migliorare l’efficienza complessiva del sistema, soprattutto nei carichi di lavoro legati ai modelli linguistici avanzati.

Vera Rubin arriverà sul mercato attraverso i nuovi sistemi DGX Rubin, che saranno disponibili dai partner Nvidia nella seconda metà del 2026. Un tempismo più ravvicinato rispetto al passato, che riflette la pressione competitiva e la volontà di Nvidia di mantenere un vantaggio strutturale nel mercato dell’infrastruttura AI.

Alpamayo e la guida autonoma basata sul ragionamento

Nel settore automotive, Nvidia ha presentato Alpamayo, una nuova famiglia di modelli open pensata specificamente per la guida autonoma. Alpamayo è progettato per portare nella guida AI un livello di ragionamento esplicito, andando oltre i sistemi che si limitano a reagire ai dati dei sensori.

Secondo Nvidia, i modelli Alpamayo non si limitano a ricevere input da telecamere, radar e lidar per poi attivare sterzo, freni e accelerazione ma analizzano le situazioni di guida, le scompongono in passaggi logici e motivano le decisioni prese, un aspetto rilevante sia per la sicurezza sia per la validazione dei sistemi autonomi.

Durante la keynote, Nvidia ha mostrato Alpamayo all’opera in contesti urbani complessi, sottolineando come il sistema sia pensato per supportare livelli avanzati di autonomia. Huang ha confermato che la prima vettura di serie a integrare questa tecnologia sarà la Mercedes-Benz CLA, con funzioni di guida AI-defined negli Stati Uniti a partire dal 2026.

Con Alpamayo, Nvidia punta a posizionarsi come fornitore di riferimento dello stack AI per la guida autonoma, offrendo non solo hardware e piattaforme, ma anche modelli aperti su cui i costruttori possono costruire e differenziare le proprie soluzioni.

Accanto al modello principale, Nvidia ha presentato anche AlpaSim, una piattaforma di simulazione open pensata per l’addestramento e il test in closed loop degli automezzi. La simulazione consente di riprodurre scenari rari o critici difficili da incontrare nella guida reale, riducendo tempi e costi di sviluppo e aumentando la copertura dei casi limite.

AI fisica, simulazione e robotica

Un altro asse centrale della presentazione di Nvidia al CES 2026 è stato il passaggio dall’intelligenza artificiale confinata al software all’AI applicata al mondo fisico. Jensen Huang ha insistito sul fatto che la prossima fase dell’AI non riguarda solo modelli sempre più grandi, ma la loro capacità di interagire con ambienti reali, macchine e infrastrutture.

In questo contesto si inserisce Cosmos, il modello di riferimento di Nvidia per robotica e simulazione. L’obiettivo è addestrare sistemi fisici attraverso ambienti virtuali ad alta fedeltà, in cui robot, veicoli e impianti industriali possono essere testati in condizioni difficili o rare prima di essere trasferiti nel mondo reale.

La simulazione viene presentata come un passaggio obbligato per ridurre tempi, costi e rischi. Nvidia ha mostrato come ambienti digitali e mondo fisico stiano convergendo, consentendo di addestrare e validare comportamenti complessi senza dover affrontare subito i limiti e le variabili della realtà.

L’AI fisica riguarda anche l’industria. Nvidia ha ribadito il ruolo della simulazione e dei modelli AI nella progettazione e gestione di impianti produttivi e sistemi automatizzati, dove fabbriche e linee di produzione vengono trattate come sistemi intelligenti, in grado di adattarsi e ottimizzare il proprio funzionamento.

La visione tracciata durante la keynote è quella di un’AI che non si limita a osservare o suggerire, ma che agisce nel mondo reale, con applicazioni che vanno dalla robotica alla logistica, fino all’automazione industriale su larga scala.

Modelli open e annunci di contorno

Accanto all’infrastruttura hardware e alle applicazioni nel mondo fisico, Nvidia ha ribadito al CES 2026 la propria strategia sui modelli open-source. Durante la keynote, Jensen Huang ha presentato un portafoglio di foundation model addestrati sui supercomputer Nvidia e pensati per coprire alcuni ambiti considerati strategici: sanità, scienze del clima, ragionamento e multimodalità, robotica, intelligenza incarnata e guida autonoma.

L’obiettivo è fornire una base comune di modelli su cui aziende, sviluppatori e istituzioni possano costruire applicazioni, mantenendo però Nvidia al centro dello stack tecnologico che rende possibile l’addestramento e la distribuzione dell’AI su larga scala.

Nella parte finale della presentazione sono arrivati anche alcuni annunci di contorno. Nvidia ha aggiornato la visione su DGX Spark come supercomputer desktop per l’AI personale, pensato per portare modelli avanzati fuori dai data center e sulla scrivania di sviluppatori e ricercatori. C’è stato spazio anche per riferimenti all’evoluzione dell’ecosistema enterprise e delle piattaforme software.

Per tutte le notizie dal CES 2026 vi rimandiamo a questa pagina di Macitynet.