Tramite comandi audio malevoli, non udibili all’orecchio umano, contenuti in musica, rumore bianco e anche in registrazioni vocali è possibile dare il via all’attacco che prende di mira svariati dispositivi su cui sono disponibili Siri, Google Assistant e anche Amazon Alexa.

Gli assistenti vocali guadagnano sempre più in comprensione e funzioni supportate, così forse era possibile prevedere l’arrivo di nuove forme di attacco basate proprio su comandi audio malevoli. La scoperta arriva da alcune ricerche universitarie realizzate sia in USA che negli Stati Uniti. In realtà questa possibilità era già stata scoperta in una ricerca dell’Università di Berkley del 2016 con comandi audio malevoli nascosti in rumore bianco, ora invece la stessa operazione è stata dimostrata anche per comandi audio malevoli nascosti nella musica e in registrazioni del parlato.

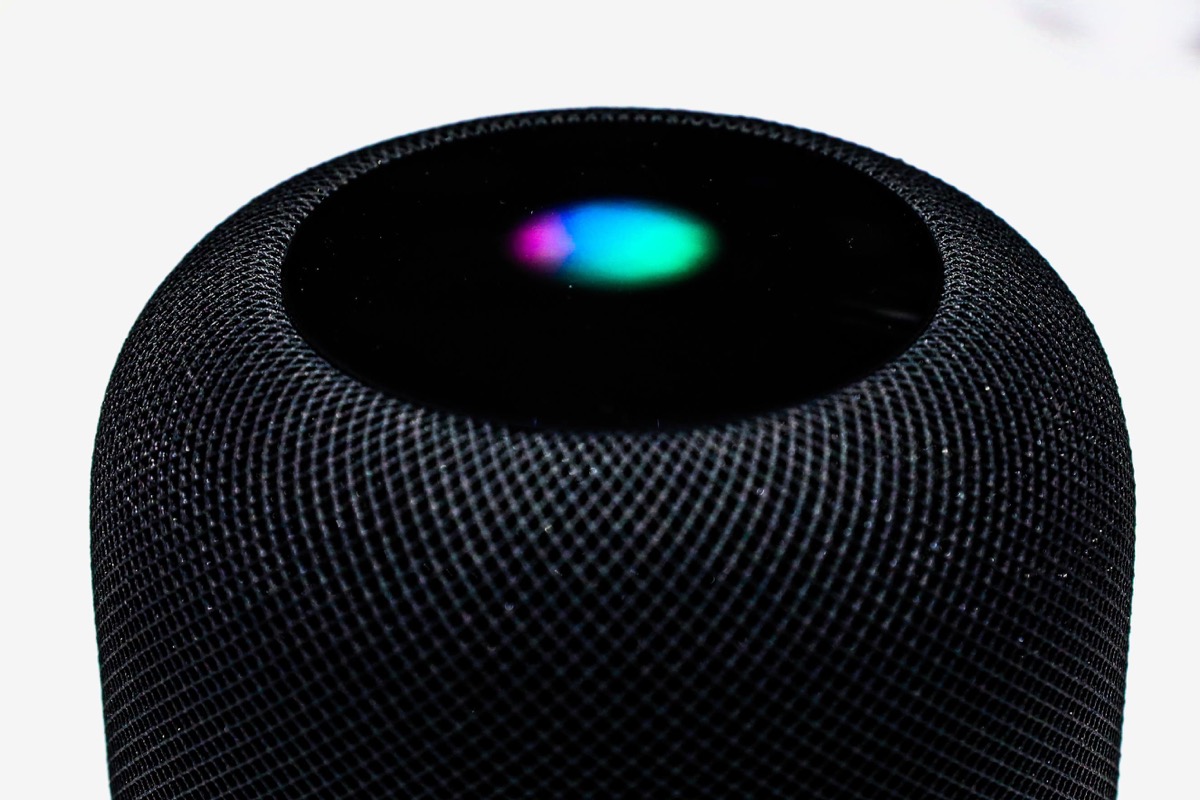

In ogni caso se la tecnologia finisse nelle mani sbagliate smartphone, speaker smart e altri dispositivi ancora potrebbero essere presi di mira per aprire porte, trasferire denaro ed effettuare acquisti online, semplicemente tramite la riproduzione di un brano musicale o di una breve registrazione vocale.

Altri esperimenti effettuati nell’Università di Zheijang in Cina e alla Princeton University in USA hanno dimostrato la possibilità di attivare comandi a frequenze non udibili per le persone, inclusa la possibilità per gli attaccanti di silenziare il telefono come primo comando, per fare in modo che l’utente non si accorga di nulla.

Per il momento però sembra che gli utenti possano stare tranquilli, soprattutto quelli di dispositivi Apple. Come anticipato non esistono prove dell’esistenza di questi tipi di attacchi, inoltre Apple, proprio per evitare questa possibilità, richiede che iPhone e iPad siano sbloccati per poter effettuare operazioni sensibili tramite comandi vocali, come per esempio l’apertura di porte, ma anche la navigazione a siti web e altro ancora.