Apple ha predisposto in iOS 15 e iPadOS 15 un sistema che negli USA scansionerà le foto caricate dagli utenti su iCloud consentendo di individuare materiale pedopornografico (CSAM, acronimo di Child Sexual Abuse Material), con l’obiettivo di riferire eventuali violazioni al National Center for Missing and Exploited Children (NCMEC), organizzazione non a scopo di lucro che si occupa – tra le altre cose – della tutela di minori scomparsi.

Dettagli sulla tecnologia che sfrutterà Apple a tutela dei minori sono stati rivelati prima dell’annuncio ufficiale da parte della Casa di Cupertino e alcuni ricercatori che si occupano di sicurezza hanno già espresso dubbi sul possibile uso/abuso di questi protocolli Apple in futuro.

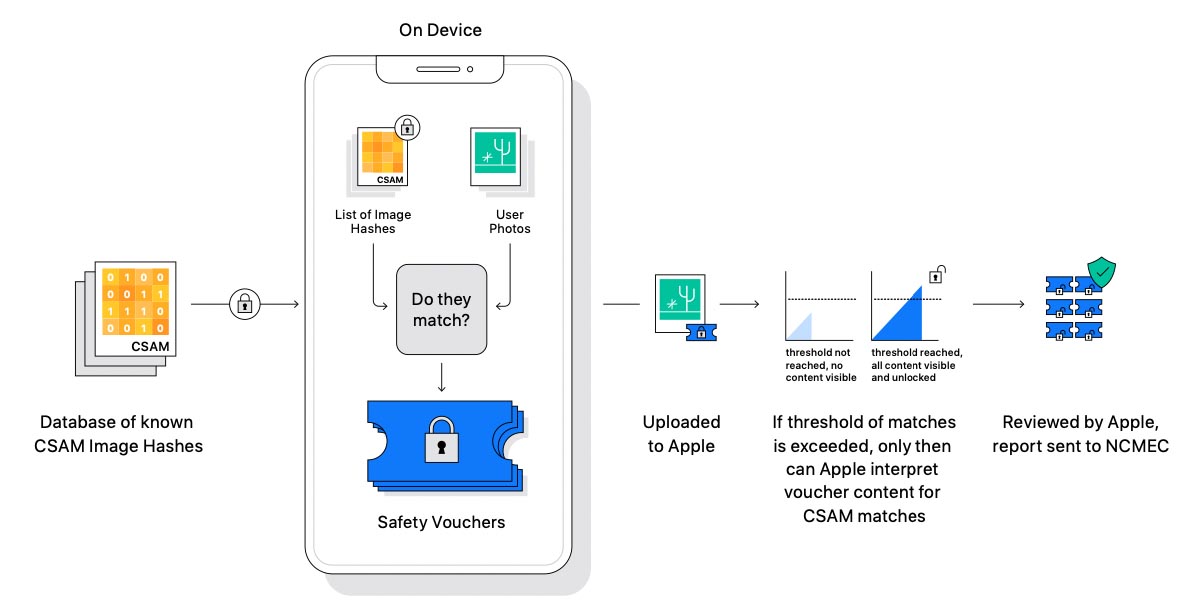

Lo riferisce Financial Times, spiegando che Apple sfrutta quello che in gergo si chiama hashing profondo per la per la ricerca di similarità, un meccanismo che consente di confrontare gli scatti caricati sul cloud con altre immagini note presenti in archivi CSAM. Se viene trovata una qualche similitudine, la foto viene caricata su iCloud con un “voucher di sicurezza crittografico” e – in determinate circostanze – scatta una procedura di revisione per verificare un legame con materiale pedopornografico.

Apple sta al momento usando la tecnologia di scansione e verifica di corrispondenze per individuare abusi sui minori ma i ricercatori riferiscono che, in futuro, lo stesso sistema potrebbe essere usato da qualche governo per obbligare la scansione di altre tipologie di immagini, es. simboli anti-governativi o immagini di proteste.

Matthew Green, ricercatore specializzato in crittografia dell’Università Johns Hopkins, in una serie di tweet afferma che questa scansione alla ricerca di similarità note, “è una pessima idea”, evidenziando che potrbebe essere sfruttata anche per la scansione di foto trasmesse con la crittografia end-to-end e non solo di quelle caricate su iCloud. Per la protezione dei minori, Apple avrebbe in effetti predisposto un meccanismo di scansione per la ricerca di contenuti sessualmente espliciti nelle foto inviate con iMessage, messaggi protetti dalla crittografia end-to-end che dovrebbe impedire la lettura nella trasmissione da un dispositivo all’altro.

Green spiega ancora che il sistema di verifica dei deep hashing potrebbe essere sfruttato da qualcuno per inviare file predisposti per fare scattare falsi positivi.

So I wrote this previous thread in a hurry and didn’t take time to spell out what it means, and what the background is. So let me try again. https://t.co/OkCgSrApXk

— Matthew Green (@matthew_d_green) August 5, 2021

Apple riferisce che la sua tecnologia di scansione vanta un “livello di precisione estremamente elevato”, rendendo improbabili i falsi positivi e ribadendo che in ogni caso è richiesta una revisione da parte di personale umano prima di inviare segnalazioni all’NCMEC.

Green è convinto ancora che l’adozione di questa tecnologia da parte di Apple spingerà altre aziende ad adottare meccanismi simili, offrendo la scusa a governi vari per predisporre controlli su tutte le tipologie di immagini possibili, strumenti di controllo da sogno per qualsiasi regime repressivo.

Anche Alec Muffett, esperto di sicurezza che in precedenza ha lavorato per Facebook, bolla l’implementazione di Cupertino come “un enorme e grave passo indietro per la privacy individuale”, arrivando ad affermare che Apple sta facendo passi indietro per stabilire uno mondo stile “1984” (il romanzo distopico di George Orwell), prefigurando situazioni, sviluppi e assetti politico-sociali altamente negativi.

Ross Anderson, professore di security engineering dell’Università di Cambridge, parla dell’idea di Apple come qualcosa di “spaventoso” che potrebbe portare ad un controllo di massa su ciò che è presente nei dispositivi degli utenti.

Altri ricercatori ancora ricordano che Google, Twitter, Microsoft, Facebook e altre aziende ancora, usano da tempo tecnologie di riconoscimento delle immagini al fine di impedire che le varie piattaforme vengano utilizzate per diffondere questo tipo di contenuti.

Google, ad esempio, spiega: “Utilizziamo […] le nostre competenze tecniche per sviluppare e condividere tecnologie gratuite che aiutano le organizzazioni a rilevare e rimuovere il materiale pedopornografico. Collaboriamo con le ONG, l’intero settore e altri, e conduciamo programmi allo scopo di condividere le nostre competenze tecniche con loro”.

Shock news, people – Twitter, Microsoft, lots of companies **do this already**. Facebook started in 2011. This is from a story I wrote in **2013**. https://t.co/8dKrm2mhj9 https://t.co/9UtDZCPJaS

— Charles Arthur (@charlesarthur) August 5, 2021

L’API Content Safety di Big G è y è uno strumento sviluppato da Google che sfrutta l’intelligenza artificiale per aiutare le organizzazioni a esaminare materiale pedopornografico, un servizio offerto gratuitamente alle ONG e alle società private per sostenere il loro lavoro a tutela dei minori. “L’identificazione più rapida di immagini nuove aumenta la probabilità che le vittime possano essere individuate e protette da ulteriori abusi. Fare in modo che le code di revisione siano più efficienti e meno caotiche contribuisce inoltre a rendere meno gravoso il lavoro di revisione da parte delle persone che esaminano manualmente le immagini”.