Nvidia ha presentato un nuovo chip top dedicato all’Intelligenza artificiale AI e applicazioni di super computing, denominato HGX H200. La piattaforma di supercomputing AI in questione (famiglia Nvidia HGX) è indicata come progettata espressamente per la convergenza di simulazioni, analisi dei dati e grandi modelli AI.

Set enormi di dati, dimensioni esplosive dei modelli e simulazioni complesse richiedono più GPU con connessioni estremamente veloci e stack software dedicati.

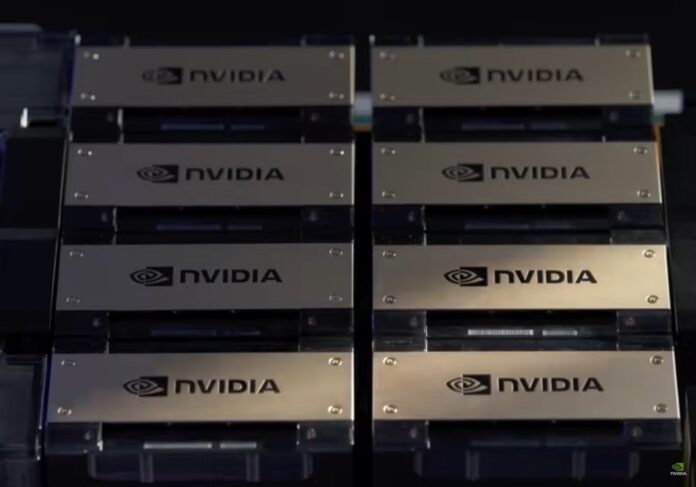

La piattaforma di supercomputing NVIDIA HGX AI offre la potenza delle GPU NVIDIA, di NVIDIA NVLink, il networking di NVIDIA Infiniband e uno stack software ottimizzato disponibile in grado di garantire le massime prestazioni applicative, elementi che permettono a ricercatori e scienziati di combinare simulazioni, analisi dei dati e AI.

HGX H200 prevede un aggiornato delle GPU, con la possibilità di gestire 1,4x la larghezza di banda permessa da H100 e ovvii benefici nella gestione di task per l’AI generativa. Nvidia riferisce che i primi chip H200 saranno disponibili nel secondo trimestre del 2024, e afferma di stare lavorando con non meglio precisati “produttori globali di sistemi e fornitori di servizi cloud”.

Dal punto di vista tecnico, la piattaforma in questione è simile all’attuale H100, sfruttabile per carichi di lavoro che devono tenere conto di modelli AI di grandi dimensioni, come i DLRM (modelli di raccomandazioni basati su deep learning) ed enormi tabelle di dati dalle quali ricavare informazioni.

Le GPU usano una memoria di nuovo tipo, denominata HBM3e, che offre larghezza di banda fino a 4,8 terabyte al secondo, superiore ai 3,35 terabyte della piattaforma H100, e la capacità di gestire fino a 141 GB di memoria, superiore agli 80 GB del sistema attuale.

“L’integrazione di memoria HBM più veloce e ampia, permette di accelerare le performance per compiti impegnativi dal punto di vista computazionale, inclusi modelli per l’AI generativa e applicazioni di high-performance computing, ottimizzando allo stesso tempo uso ed efficienza della GPU”, dichiara Ian Buck, vice presidente responsabile high-performance computing products di Nvidia.

H200 è compatibile con i sistemi che già supportano H100, e tra le prime aziende che prevedono di sfruttare questi sistemi ci sono Amazon, Google, Microsoft e Oracle.

Nvidia non ha indicato dettagli sui costi ma secondo quanto riferisce CNBC, l’attuale generazione Nvidiai H100 costa tra i 25.000$ e i 40.000$ per unità (da 23.00 euro a 37.00 euro circa), e bisogna tenere conto che servono anche migliaia di questi sistemi per offrire funzionalità ai massimi livelli.

Le schede base dei server dedicati, possono essere combinate utilizzando interconnessioni NVSwitch per creare potenti nodi singoli con GPU multiple, le basi per piattaforme di supercomputing AI.

Per tutto ciò che riguarda l’Intelligenza artificiale rimandiamo alla sezione dedicata di macitynet.