Apple ha risposto ad una serie di domande riguardanti l’attivazione di una nuova funzionalità che in iOS 15, iPadOS 15 e macOS Monterey permetterà di individuare immagini pedopornografiche nei dispositivi, funzione richiesta e apprezzata da vari gruppi che si occupano della tutela dei minori ma che alcuni esperti di privacy temono possa essere in futuro essere usata per controllare anche altre tipologie di immagini da parte di governi e regimi vari.

Apple – scrive Macrumors – ha confermato che in futuro intende aprire anche a terzi la funzionalità che consente di rilevare automaticamente immagini pedopornografiche, un meccanismo che prevede controlli per le immagini caricate sul cloud, effettuando verifiche tenendo conto della similitudine con archivi noti di immagini di questo tipo.

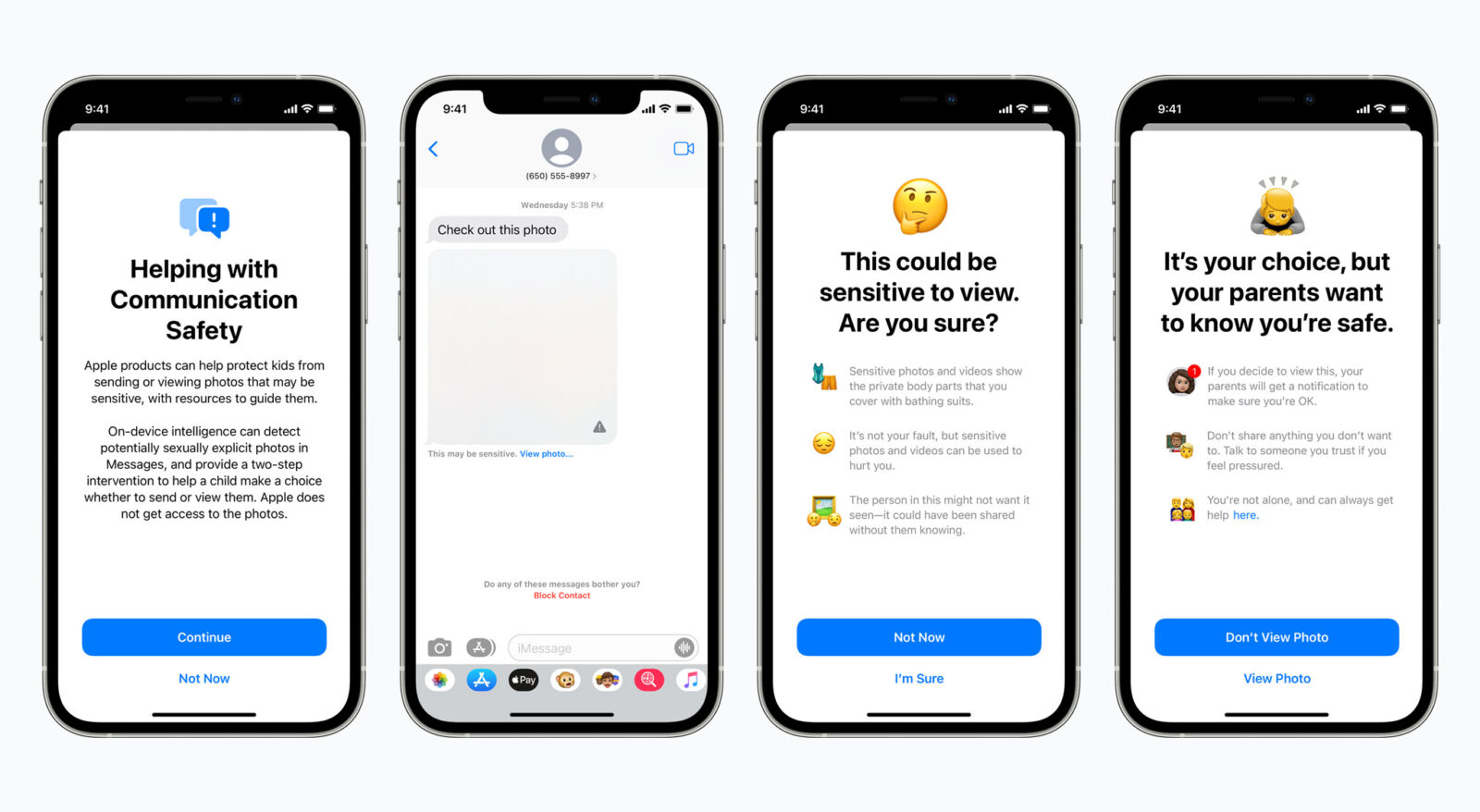

Apple non ha al momento fatto annunci specifici ma ha spiegato che espandere le funzionalità di sicurezza, permettendo anche a terze parti di usarle, è per loro un obiettivo auspicabile. L’idea potrebbe essere quella di consentire verifiche anche per le immagini caricate/scambiate su piattaforme quali Snapchat, Instagram o WhatsApp, offuscando automaticamente determinati tipi di immagini, chiedendo all’utente conferma prima di mostrarle effettivamente (e segnalare ai genitori l’arrivo di determinate foto) . Una diversa ipotesi potrebbe essere quella di espandere il sistema di verifica, effettuando l’analisi delle caratteristiche delle immagini anche quando queste sono caricate su servizi diversi da iCloud Foto.

La Casa di Cupertino non ha indicato date relativamente alla possibilità di offrire anche a terze parti i controlli anti-pedopornografia ed ha ribadito che una simile possibilità richiederà test e prove, garantendo che qualsiasi eventuale apertura verso terzi non pregiudichi privacy ed efficacia della funzione.

Pochi giorni addietro è stato attivato un sito dove chiunque può firmare per chiedere a Apple dion portare avanti i piani che prevedono funzionalità per l’identificazione automatica di immagini pedopornografiche caricate su Foto per iCloud o scambiate dagli utenti con l’app Messaggi.