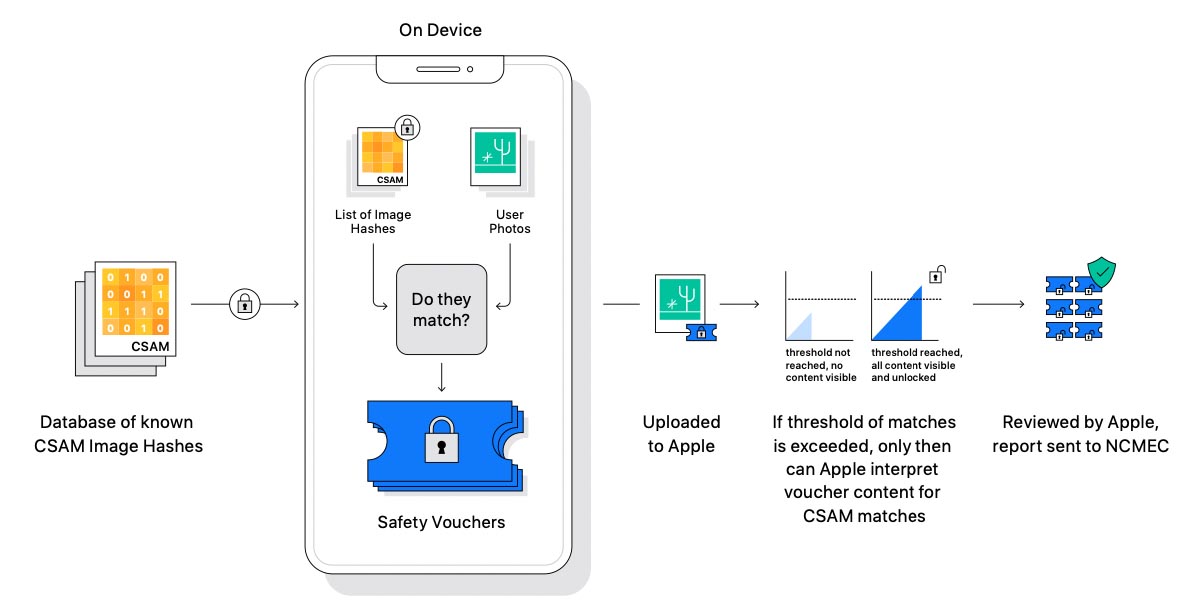

Continua a fare discutere il sistema antipedofilia annunciato da Apple, questa volta commenti e critiche decisamente più costruttive arrivano dall’ex capo sicurezza di Facebook. Cupertino con gli aggiornamenti in arrivo di iOS 15, iPadOS 15 e macOS Monterey, ha predisposto una funzionalità che consentirà di “scansionare” le immagini caricate su iCloud Foto per individuare automaticamente materiale pedopornografico, attivando un meccanismo di allarme che farà scattare controlli da parte di personale specifico di Apple il quale segnalerà eventuali abusi alle associazioni che si occupano della tutela dei minori.

Oltre alla funzione che scandaglia le foto caricate su iCloud, una diversa funzione, consente di offuscare automaticamente questo tipo di materiale (potranno essere aperte solo dopo l’esplicito consenso), notificando i genitori qualora i figli minorenni ricevano su iMessage foto pedopornografiche.

La nuova funzionalità è stata apprezzata da alcune associazioni (che si sono congratulate con Apple per la scelta) ma preoccupa altre (es. l’Electronic Frontier Foundation, EFF) che vedono il sistema di scansione come una clamorosa invasione della privacy chiedendosi cosa accadrebbe se un domani Apple modificasse il sistema per identificare non solo materiale pedopornografico, ma ad esempio anche simboli e immagini poco gradite a governi e regimi vari.

Tra le tante voci contrarie alla sistema antipedofilia di Apple (che ha cercato di rassicurare tutti con una prima serie di FAQ sull’argomento), c’è anche Alex Stamos, ex security chief di Facebook, che ha scritto su Twitter un thread per spiegare che non esistono “risposte facili” su questioni che mettono sullo stesso livello la privacy e la protezione dei bambini.

Stamos esprime disappunto sulla modalità con la quale Apple ha gestito la nuova funzione criticando l’azienda per non avere mai partecipato negli ultimi anni a discussioni con il settore nel suo complesso su argomenti quali sicurezza, privacy e aspetti relativi alla cifratura end-to-end. A detta di Stamos, Apple è stata in altre occasioni invitata ma non ha mai partecipato a queste discussioni; con l’ultimo annuncio hanno distrutto le possibilità di confronto, spingendo tutti all’angolo, senza pensare a una consultazione pubblica o dibattiti in merito.

L’ex dirigente Facebook riferisce ancora di essere deluso dalle reazioni sul sistema antipedofilia Apple di organizzazioni quali l’Electronic Frontier Foundation (EFF) e il National Center for Missing & Exploited Children (NCMEC) per avere lasciato poco margine alle discussioni nelle loro dichiarazioni pubbliche. L’NCMEC, ad esempio, ha definito i dipendenti Apple che hanno sollevato dubbi in merito ad implicazioni legate alla privacy, “stridenti voci della minoranza”, persone che si sarebbero a loro modo viste spinte a difendere in modo “estremo” le loro posizioni.

The chatter around Apple's recent announcement of new child safety protections is rather frustrating, as the amplification/knowledge ratio seems rather high on this one.

Apple's docs: https://t.co/TIcVQ6Zb1J

A discussion with friends: https://t.co/c4IYPVMHUA

— Alex Stamos (@alexstamos) August 7, 2021

Stamos esorta i ricercatori che si occupano di sicurezza e gli attivisti che affermano di essere sorpresi dalla scelta di Apple a prestare attenzione a quanto sta avvenendo nel contesto normativo globale, facendo capire che l’Online Safety Bill britannica (disegno di legge sulla sicurezza) e la proposta legislativa europea del Digital Services Act (con le piattaforme online che dovranno agire come gatekeeper, prevedendo un nuovo sistema di segnalazione di contenuti illeciti), sono alcuni degli elementi determinati che hanno portato Apple verso questa scelta.

«Uno dei problemi fondamentali nell’approccio di Apple”, scrive ancora Stamos, “[…] è l’assenza di vere funzionalità di tutela e sicurezza per i loro prodotti dedicati alla comunicazione. Non c’è ad esempio un meccanismo per segnalare spam, minacce di morte, incitamento all’odio, NCII (immagini intime non consensuali, ndr) o altri tipi di possibili abusi con iMessage».

Secondo Stamos, Apple non offre sufficienti funzionalità dedicate alla tutela e alla sicurezza e invita Apple a creare un sistema di reporting in iMessage, creare meccanismi client-side che (grazie al Machine Learning) suggeriscano all’utente di denunciare abusi, creare un team per la sicurezza che si occupi nello specifico di bambini per indagare sui più terribili resoconti.

«Abbiamo, invece, un sistema di machine learning che ha come target solo i ragazzi di (meno di) 13 anni, non il gruppo di riferimento che – secondo la mia esperienza – costituisce il gruppo dove si registrano i maggiori problemi come sextortion (ricattatori che minacciano le vittime di pubblicare foto o video compromettenti) e adescamento”, problemi che non sono considerati da Apple e per i quali le associazioni che si occupano della loro tutela e i genitori non ricevono nessuna notifica».

Stamos riferisce ancora che su Facebook sono stati identificati 4,5 milioni di utenti che scambiavano materiale con abusi sui minori, e che si tratta probabilmente solo di una piccolissima parte delle persone che è possibile identificare con i meccanismi automatici di scansione di questa tipologia di immagini.

Tutti gli articoli di macitynet che parlano di Privacy e Sicurezza sono disponibili ai rispettivi collegamenti.