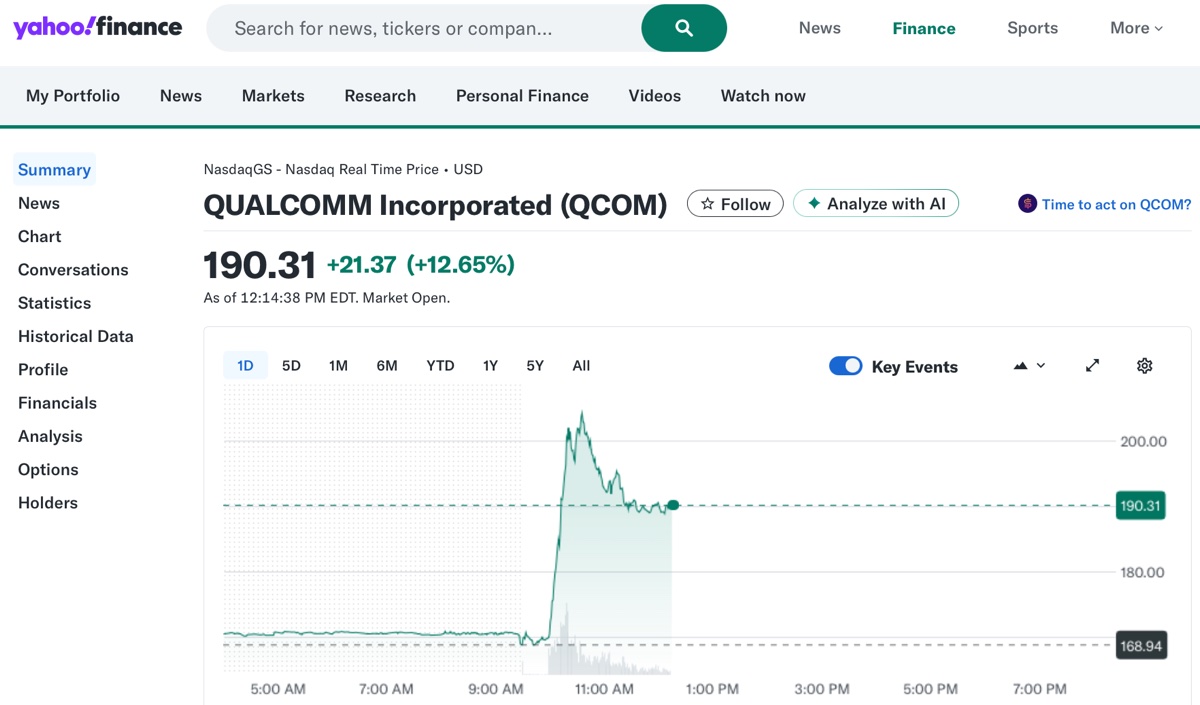

Durante la giornata di lunedì 27 ottobre le azioni Qualcomm sul NASDAQ sono arrivate a segnare oltre +12% sulla scia della notizie di due nuovi chip per Intelligenza Artificiale AI destinati a rack e data center. Qualcomm è nota soprattutto per chip e modem destinati ai dispositivi portatili, ma le sue piattaforme spaziano dalle tecnologie di rete ai chip per computer, passando per automobili e dispositivi indossabili.

L’espansione dell’offerta prosegue con la presentazione di Qualcomm AI200 e AI250 in grado di offrire elevate prestazioni e capacità di memoria per applicazioni di AI generativa e inferenza, con costi complessivi inferiori rispetto alla soluzioni attuali. Il costruttore dichiara che queste schede di accelerazione per inferenza sono basate sulle tecnologie Qualcomm nel settore Neural Processing Unit – NPU.

Qualcomm AI200 e AI250

Qualcomm AI200 offre una basso costo totale e prestazioni ottimizzate per l’inferenza di modelli linguistici e multimodali LLM e LMM di grandi dimensioni. Ogni scheda supporta 768 GB di memoria LPDDR e sarà disponibile nel 2026.

Invece nel 2027 sarà disponibile Qualcomm AI250 con una innovativa architettura di memoria basata sulla tecnologia near-memory computing. Secondo la multinazionale offrirà un balzo generazionale in termini di efficienza e prestazioni per carichi di lavoro di inferenza AI, con una larghezza di banda di memoria effettiva 10 volte superiore e consumi energetici sensibilmente inferiori.

Pacchetto completo

Le due piattaforme supportano il raffreddamento liquido diretto, PCI per la scalabilità ed Ethernet per il collegamento tra nodi, oltre all’elaborazione protetta dei carichi di lavoro AI per la privacy.

Ancora, le due piattaforme includono software completo per velocizzare installazione, gestione, programmazione e scalabilità, con compatibilità con i framework AI più diffusi e installazione one-click dei modelli Hugging Face.

Sfida a Nvidia solo in parte

L’annuncio precisa più volte che i chip AI Qualcomm sono progettati e destinati all’inferenza, per l’esecuzione dei grandi modelli AI nel cloud, quindi di modelli che hanno già superato la fase di addestramento.

Anche se il mercato ha reagito con grande ottimismo per la possibilità di Qualcomm di sfidare Nvidia nei lucrativi data center, la competizione non riguarda il training, dove al momento i chip e e tecnologie Nvidia rimangono dominanti.

Tutte le notizie che parlano di Intelligenza Artificiale sono disponibili a partire da questa pagina di macitynet.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)