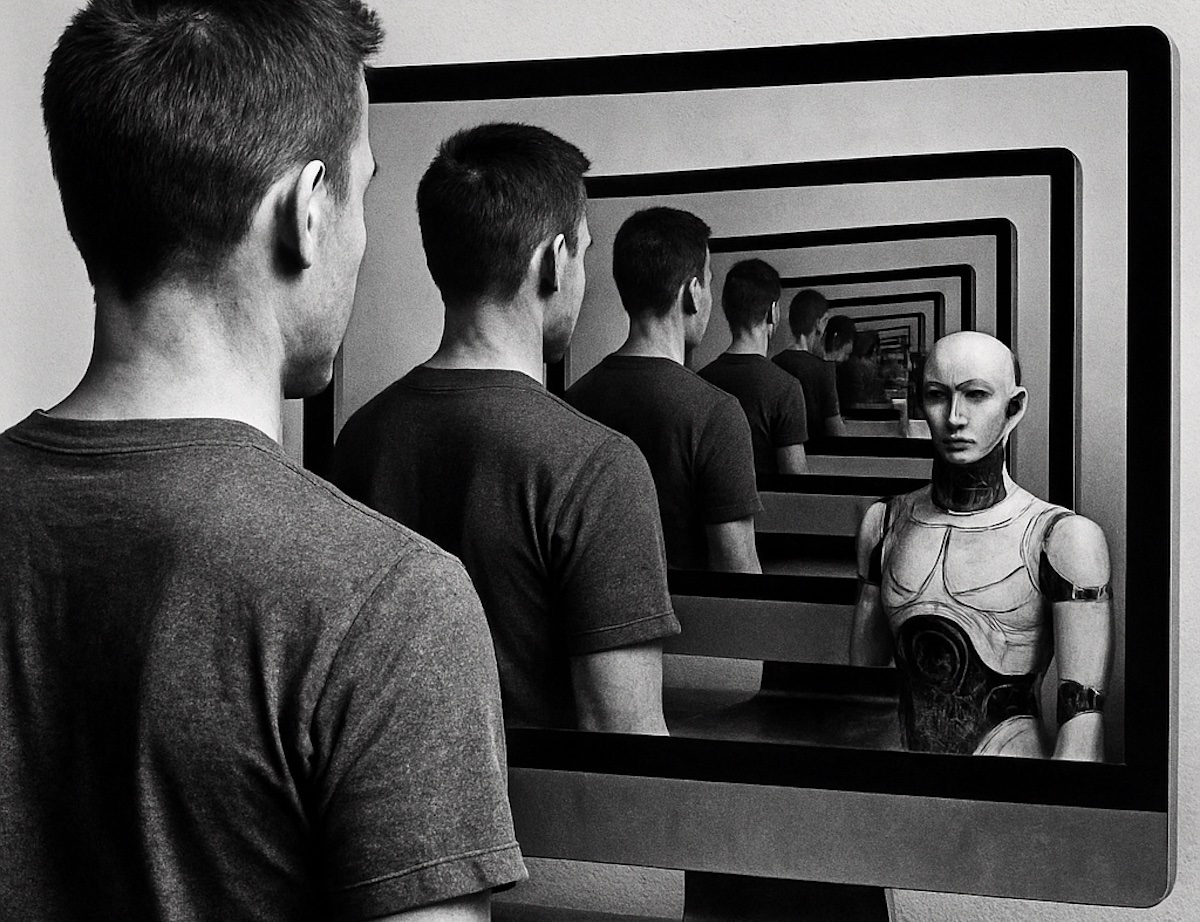

Le super-intelligenze artificiali (ASI) sono sistemi di intelligenza artificiale (AI) basati su software con una portata intellettuale che va oltre l’intelligenza umana. Anche se al momento si tratta di progetti e non esistono (ufficialmente) nella realtà c’è una grande preoccupazione da parte di scienzati e tecnici sull’uso di una tecnologia che potrebbe finire fuori controllo con effetti devastanto.

Un appello a fermarne lo sviluppo è stato organizzato dal Future of Life Institute (FLI), ente nonprofit che mira a un’evoluzione etica dell’AI.

Tra i firmatari dell’appello troviamo premi Nobel, esperti di sicurezza nazionale, importanti ricercatori nel settore AI e autorità religiose che vogliono “proibire lo sviluppo di superintelligenze fino a quando la tecnologia non sarà affidabile, sicura e controllabile”, e siano predisposti meccanismi di consenso che attualmente non sono presenti.

Tra i tanti troviamo: l’attore e regista Joseph Gordon-Levitt, il rapper e produttore discografico will.i.am, lo psicologo e informatico Geoffrey Hinton, l’imprenditore e filantropo Richard Branson e il co-fondatore di Apple, Steve Wozniak.

“Innovativi strumenti di AI potrebbero portare a salute e prosperità senza precedenti”, si legge nell’appello; “Tuttavia, insieme a questi strumenti, molte importanti aziende leader nel settore AI si sono date per il prossimo decennio l’obiettivo di creare superintelligenze in grado di superare in modo rilevante gli esseri umani essenzialmente su tutti i compiti cognitivi. Tutto questo solleva preoccupazioni su questioni che vanno dall’obsolescenza economica umana, alla perdita di potere delle classi inferiori, fino alla mancanza di libertà, diritti civili, dignità e controllo, per passare a rischi che riguardano la sicurezza nazionale e potenzialmente anche l’estinzione umana”.

“Questa breve dichiarazione”, si legge ancora nel sito dove è possibile firmare l’appello, “mira a creare conoscenza comune del crescente numero di esperti e personaggi pubblici che si oppongono alla superintelligenza”.

Pericoli delle super-AI

Le AI cosiddette “deboli” eccellono in attività specifiche come il gioco degli scacchi o la traduzione di lingue, ma non possono apprendere nuove skill o sviluppare una profonda comprensione del mondo (si basano su algoritmi e dati preprogrammati e richiedono l’intervento dell’uomo per poter funzionare). Il passaggio per lo sviluppo di un’ASI potrebbe essere quello di realizzare un’intelligenza artificiale generale (AGI) o AI “forte”, in grado di comprendere il mondo e imparare e applicare l’intelligenza per la risoluzione dei problemi nel modo più ampio e flessibile possibile, come farebbe un essere umano. Una super-intelligenza potrebbe apprendere in modo intersettoriale, “ragionare” con la capacità di fare collegamenti tra diversi campi.

Non mancano rischi: le super-intelligenze potrebbero superare il controllo umano e diventare autoconsapevoli, con conseguenze potenzialmente impreviste e persino a rischi esistenziali. Le capacità cognitive superiori potrebbero consentire di manipolare interi sistemi e persino portare al controllo di armi avanzate, a disordini economici e sociali, esacerbare disuguaglianze esistenti e sconvolgere interi settori industriali.

Per tutti gli articoli sull’Intelligenza Artificiale rimandiamo alla sezione dedicata di macitynet.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)