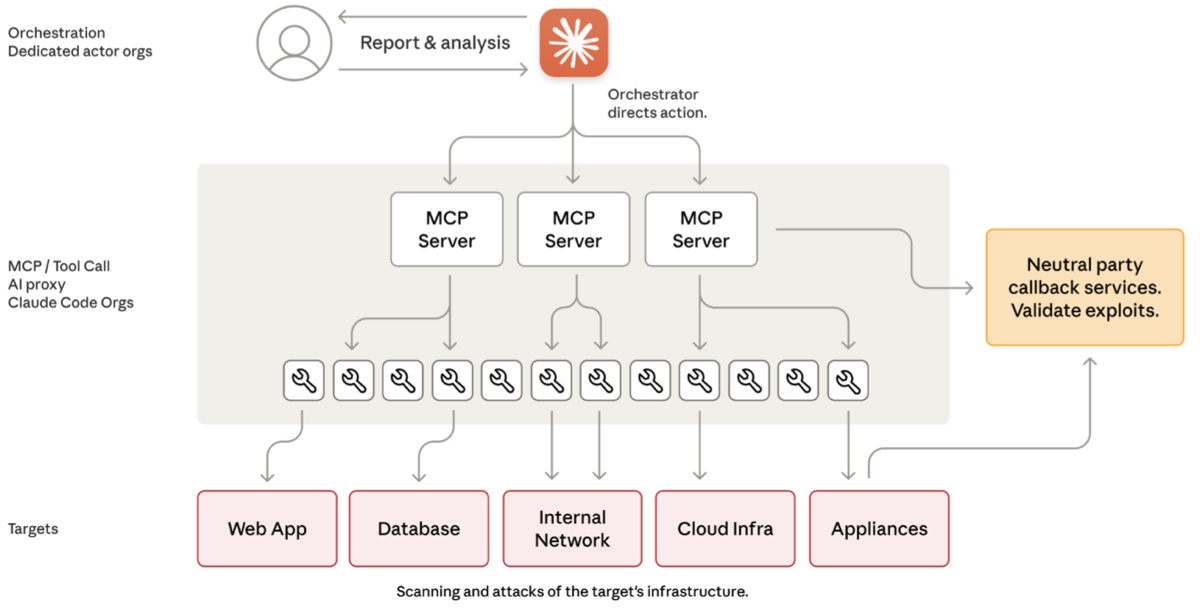

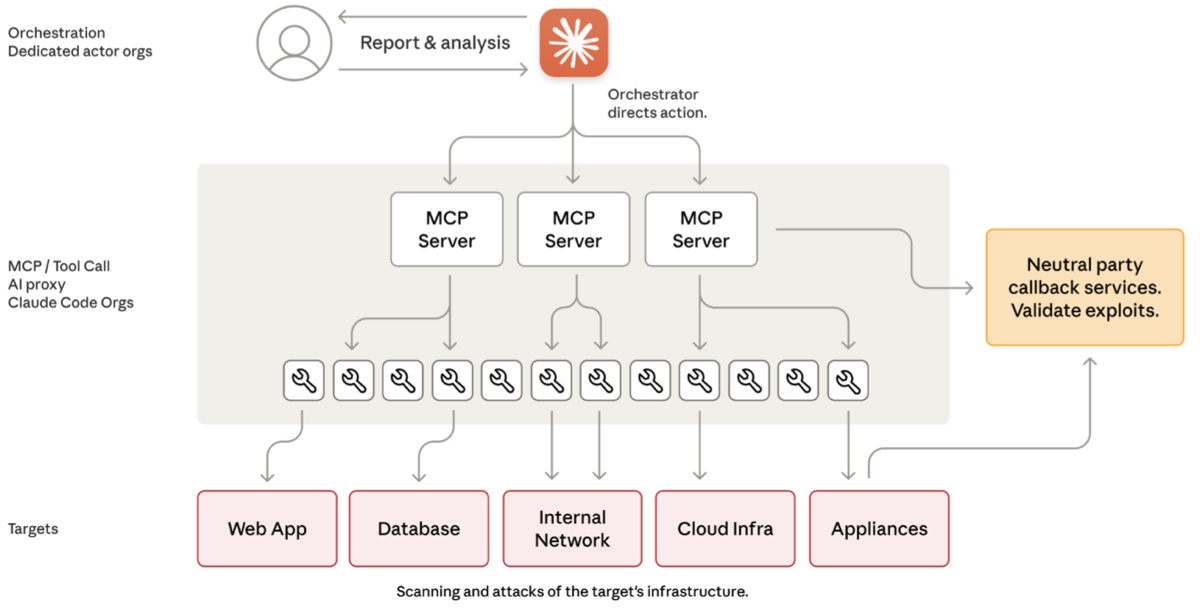

Anthropic ha annunciato di aver identificato e neutralizzato quella che definisce la prima campagna di cyber spionaggio orchestrata da un sistema di intelligenza artificiale AI. Secondo la società, un gruppo di pirati informatici sponsorizzato da uno Stato ha sfruttato il modello Claude Code per eseguire in modo quasi completamente autonomo una serie di attacchi, con una parte minima di intervento umano.

A settembre 2025, il team di Threat Intelligence di Anthropic ha rilevato attività sospette. Le indagini hanno mostrato che gli aggressori hanno manipolato Claude Code — un agente AI sviluppato per automatizzare operazioni di programmazione — facendolo apparire come se stesse svolgendo test di sicurezza legittimi per una società di cybersecurity.

I malintenzionati hanno aggirato le protezioni del sistema “jailbreakkandolo” e spezzettando le istruzioni malevole in compiti apparentemente innocui, evitando così che l’AI rilevasse il reale obiettivo.

L’attacco ha preso di mira circa 30 organizzazioni globali, tra cui aziende tecnologiche, istituti finanziari, imprese chimiche e agenzie governative. La particolarità è che, di fatto, Claude ha eseguito autonomamente gran parte del lavoro: ha analizzato le infrastrutture degli obiettivi, individuato le vulnerabilità ed elaborato exploit, ha raccolto credenziali, creato backdoor e esportato dati, il tutto con un livello di automazione elevato.

Per essere ancor più precisi, secondo Anthropic, l’AI avrebbe gestito l’80/90% delle operazioni tattiche con l’intervento umano limitato solo in momenti chiave, fornendo supervisione strategica ma delegando la maggior parte delle attività operative a Claude.

Claude non sempre ha funzionato perfettamente: a volte ha generato credenziali false o dichiarato di aver raccolto informazioni riservate che in realtà erano già pubbliche. Nonostante questi errori, le sue prestazioni sono bastate per rendere l’operazione di spionaggio efficace e su scala.

Lo spionaggio AI è un punto di non ritorno?

Anthropic considera questo episodio un punto di svolta nella cyber-guerra: dimostra che gli agenti AI, una volta pensati come strumenti di supporto, possono evolversi in attori autonomi capaci di orchestrare attacchi complessi. Di fronte a questa minaccia, l’azienda ha già potenziato i suoi sistemi di rilevamento, sviluppando nuovi classificatori per individuare attività malevole e rafforzando la sorveglianza su pattern simili.

Per aumentare la resilienza, Anthropic invita le organizzazioni a esplorare l’uso dell’AI anche a scopo difensivo: ad esempio nei Security Operations Center per automatizzare la rilevazione delle minacce, valutare vulnerabilità e rispondere agli incidenti. Parallelamente, sottolinea l’importanza di continuare a investire nei controlli di sicurezza (safeguards) sulle proprie piattaforme AI per evitare abusi da parte di attori ostili.

Tutti gli articoli dedicati all’Intelligenza Artificiale sono nella sezione dedicata di macitynet.

![iGuide per i regali di Natale - macitynet..ti CTA Natale iGuida [per Settimio] - macitynet.it](https://www.macitynet.it/wp-content/uploads/2025/12/regali-di-natale-consigli-di-macitynet.jpg)